Cuando decimos La muerte de la Keyword exacta: Lo que la integración de Algolia + Amazon Bedrock nos enseña sobre el futuro del SEO Semántico, describimos un salto tecnológico y estratégico: pasar de un SEO “string-based” a un SEO Semántico donde la relevancia se calcula con vectores y modelos generativos que “comprenden” relaciones conceptuales. En este artículo exploramos el porqué, el cómo y el cuánto cuesta, con un enfoque práctico para desarrolladores y responsables de crecimiento.

Qué implica realmente Algolia + Amazon Bedrock

Algolia evolucionó de un motor de índice invertido ultrarrápido a una plataforma con capacidades neuronales y de búsqueda vectorial (por ejemplo, su enfoque de NeuralSearch e integración de embeddings). Amazon Bedrock ofrece acceso gestionado a modelos fundacionales (LLMs y modelos de embeddings) de múltiples proveedores —incluyendo Amazon Titan y opciones de terceros— con APIs consistentes, seguridad y gobernanza. La suma permite:

- Indexación híbrida (lexical + vectorial): matches por tokens + similitud semántica en el mismo flujo.

- Relevancia por intención: consultas diferentes que expresan la misma necesidad devuelven resultados similares.

- Answers y resúmenes con RAG: LLMs generan respuestas citando documentos recuperados por Algolia.

- Personalización: contexto del usuario inyectado en prompts y/o re-ranking.

- Governance: auditar prompts, registrar eventos de búsqueda, controlar PII y cumplimiento.

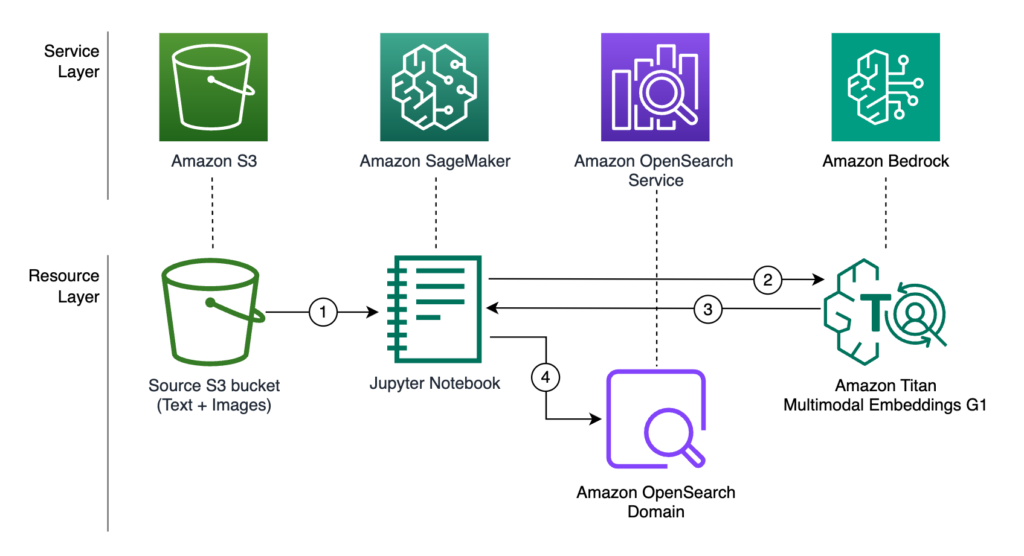

Arquitectura de referencia (alto nivel)

- Ingesta y normalización: extrae contenidos (catálogo, blog, docs) y normaliza a un esquema común.

- Chunking semántico: divide textos en trozos coherentes (párrafos, secciones, descripciones).

- Embeddings: usa Amazon Bedrock para generar embeddings (p. ej., Amazon Titan) por chunk.

- Indexación en Algolia: almacena documentos con campos textuales, metadatos, facetas y vectores.

- Búsqueda híbrida: para cada query, Algolia combina ranking lexical + vectorial, con rules y synonyms.

- RAG opcional: recupera los top‑K resultados, forma un prompt con contexto y llama a un LLM en Bedrock para generar una respuesta.

- Re-ranking/Personalización: ajusta con señales de comportamiento, perfiles, stock, margen, frescura.

- Observabilidad: métricas de precisión, CTR, satisfacción, latencia y costes.

Este patrón prueba que la coincidencia exacta dejó de ser la métrica reina. Ahora ganan los documentos más útiles para la intención del usuario, aunque no compartan la misma cadena de texto de la consulta.

Del keyword matching al SEO Semántico

Si tu estrategia dependía de “concordancia exacta” (“comprar zapatillas rojas baratas mujer”), el nuevo entorno la vuelve frágil. Con embeddings y re-ranking contextual:

- Paráfrasis y sinonimia: “zapatillas mujer económicas rojas” ≈ “tenis rojos baratos para mujer”.

- Entidades y atributos: talla, color, marca, intención transaccional o informacional.

- Contexto del usuario: histórico, ubicación, stock local, preferencia de marca.

- Multimodalidad (en crecimiento): imagen+texto, manuales PDF, vídeos.

Implicaciones de contenido

- Escribe para cubrir la intención, no para repetir términos. Cubre entidades, propiedades y variantes.

- Estructura semánticamente (H2/H3, listas, tablas) para facilitar el chunking y el ranking.

- Schema.org/JSON‑LD: define entidades (Product, FAQPage, Article) y relaciones.

- Datos enriquecidos: especificaciones, preguntas frecuentes, comparativas, benefits vs. features.

- Recency y frescura: en dominios sensibles al tiempo.

Este giro —la muerte de la keyword exacta en favor del significado— no solo afecta a Google. Se vuelve crítico en buscadores internos, donde convertir y retener es inmediato.

Cómo diseñar tu índice en Algolia para búsqueda semántica

Campos recomendados

- title, subtitle, description, body: textos base.

- facets: marca, precio, categoría, disponibilidad, idioma.

- structured_attributes: tamaño, compatibilidad, materiales, tags.

- vector: embedding del chunk o documento (desde Bedrock).

- popularity signals: ventas, CTR, add‑to‑cart, dwell time.

- freshness: timestamps, flags de actualización.

Buenas prácticas técnicas

- Hybrid scoring: activa búsqueda lexical y vectorial. Ajusta pesos con A/B testing.

- Synonyms inteligentes: aprovecha reglas de Algolia y complementar con embeddings para candidatos.

- Faceting + filters: reduce el espacio de búsqueda con filtros contextuales.

- Chunking coherente: evita trozos demasiado pequeños; mantén consistencia semántica.

- Versiona embeddings: si cambias de modelo, vuelve a indexar y etiqueta la versión.

- Latency budgeting: caching de resultados y de respuestas RAG, timeouts controlados.

Orquestación de embeddings con Amazon Bedrock

Bedrock simplifica la elección y operación de modelos de embeddings y LLMs. Puntos clave:

- Modelos de embeddings: opciones gestionadas (por ejemplo, Amazon Titan) para múltiples idiomas.

- Consistencia de API: cambia de modelo sin reescribir toda tu infraestructura.

- Privacidad y cumplimiento: aislamiento de datos, control de regiones y cifrado.

- Tooling: evaluación, monitoreo de prompts, cuotas, y trazabilidad.

Pipeline sugerido

- Limpieza y normalización (HTML → texto estructurado).

- Chunking por semántica y longitud target (p. ej., 300–800 tokens).

- Embeddings en lote via Bedrock, guardando vector y metadata.

- Upsert en Algolia con campos lex y vectoriales.

- Query‑time: genera embedding de la consulta (o usa patrones precomputados) y ejecuta búsqueda híbrida.

- RAG: formatea contexto, llama a un LLM de Bedrock, cita fuentes.

Con esto, La muerte de la Keyword exacta: Lo que la integración de Algolia + Amazon Bedrock nos enseña sobre el futuro del SEO Semántico deja de ser un eslogan y se convierte en una arquitectura aplicable.

Consejos prácticos para equipos SEO y Dev

- Define intenciones por categoría: informacional, transaccional, comparativa, posventa.

- Mapea entidades (producto, marca, problema, solución) y relaciones.

- Escribe FAQs con lenguaje natural, no solo con keywords exactas.

- Usa snippets y resúmenes fácilmente citables por RAG.

- Evalúa con usuarios: tareas reales, queries ambiguas y long tail.

- Instrumenta métricas: NDCG@k, Recall@k, CTR, tasa sin resultados, tiempo a primer clic.

- Haz A/B testing al ajustar pesos lexical vs. vectorial.

- Controla costes con batch embeddings, caché y límites de RAG por tipo de página.

Ventajas clave frente a la búsqueda tradicional

- Mejor cobertura semántica: reduce “no results” incluso con consultas vagas.

- Relevancia por intención: resultados que responden lo que el usuario quiso decir.

- Menos dependencia de sinónimos manuales y listas infinitas.

- Personalización granular sin romper la relevancia general.

- Contenido evergreen reutilizable en múltiples queries relacionadas.

Precios y costes: cómo estimarlos sin sorpresas

El coste total suele dividirse en tres bloques: Algolia, Amazon Bedrock y operación. Las cifras exactas cambian por región, modelo y uso; considera lo siguiente como orientativo y valida siempre en las páginas oficiales.

Componentes de coste

- Algolia:

- Registros y operaciones: coste por volumen de records y operaciones de búsqueda/índice.

- Funciones avanzadas: búsqueda vectorial/neural y personalización pueden requerir planes superiores.

- Tráfico: picos de consultas elevan el coste variable.

- Amazon Bedrock:

- Embeddings: precio por 1K tokens procesados (batch para abaratar).

- Inferencia LLM: coste por 1K tokens de entrada/salida; varía según el modelo.

- Almacenamiento/transferencia: si integras con otros servicios de AWS.

- Operación:

- Orquestación: pipelines, colas, funciones o contenedores.

- Observabilidad: logs, métricas, dashboards.

- Re-embeddings periódicos: cuando cambian modelos o contenidos.

Ejemplo hipotético (para dimensionar)

- Catálogo: 200K productos, 1M chunks totales con descripciones ampliadas.

- Embeddings: 1M chunks, 500 tokens promedio por chunk → 500M tokens de embeddings en batch.

- Consultas: 2M búsquedas/mes; 10% activa RAG con 1K tokens de salida promedio.

En un escenario así:

embeddings constituirán un coste grande al inicio (batch), pero se amortiza; el RAG dominará el coste variable mes a mes. El coste Algolia dependerá de tu plan y del volumen de operaciones. Para controlar gastos:

- Caché de respuestas RAG para queries populares.

- Top‑K ajustado en recuperación (no recuperar más de lo necesario).

- Re-embed selectivo solo cuando cambie el contenido o el modelo.

- Guardrails y límites de tokens en prompts.

Métricas que importan en la era post-keyword exacta

- Recall@K y NDCG@K: calidad de recuperación y ranking.

- CTR y “no results” rate: señales de descubrimiento efectivo.

- Conversiones: add‑to‑cart, registros, leads generados.

- Tiempo a primer resultado útil: latencia percibida.

- Uso de filtros/facetas: necesidad de refinar por falta de pertinencia.

- Satisfacción: encuestas in‑search y thumbs up/down en respuestas.

Consejo: crea un panel unificado que combine métricas de Algolia y Bedrock con analítica de negocio.

Estrategias de contenido para SEO Semántico real

Clústeres temáticos y entidades

- Topic clusters que mapeen la intención: guías, comparativas, problemas frecuentes.

- Entidades y atributos explícitos en texto y en JSON‑LD.

- FAQs y “cómo elegir” con lenguaje natural y variaciones.

Patrones editoriales eficaces

- Snippets autoportantes: párrafos cortos que permitan buenas citas RAG.

- Tablas/listas claras de pros/cons, specs y compatibilidad.

- Contenido comparativo entre modelos/marcas con criterios objetivos.

Así, “La muerte de la keyword exacta” se traduce en mejor cobertura semántica y descubrimiento orgánico robusto.

Internacional y español: consideraciones especiales

- Embeddings multilingües: usa modelos que representen bien el español y sus variantes.

- Normalización: acentos, lematización, sinónimos regionales (“ordenador” vs. “computadora”).

- Contenido localizado: no solo traducido; ajusta ejemplos y vocabulario.

- Detección de idioma a nivel de query y de documento.

Riesgos y anti‑patrones comunes

- Vectorización indiscriminada: embedir todo sin estrategia eleva costes y ruido.

- Chunking errático: trozos mal segmentados confunden el ranking.

- RAG sin citaciones: respuestas difíciles de auditar y poca confianza.

- Olvidar señales de negocio: margen, stock y frescura deben pesar en el ranking.

- Falta de evaluación: sin golden sets y A/B testing, vas a ciegas.

Roadmap recomendado (90 días)

Días 1–30: Fundamentos

- Auditoría de contenidos y definición de intenciones.

- Diseño de esquema de índice y metadatos.

- Piloto de embeddings con un subconjunto representativo.

- Primer A/B de lexical vs. híbrido en una categoría.

Días 31–60: Escalado controlado

- Re-embedding y cobertura ampliada.

- RAG limitado a páginas de alto valor (soporte o comparativas).

- Observabilidad y dashboards con métricas clave.

- Synonyms asistidos con señales de embedding + analítica.

Días 61–90: Optimización

- Re-ranking con señales de negocio y personalización.

- Guardrails y políticas de prompts.

- Refinamiento de chunking y pesos híbridos por vertical.

- Plan de costes con presupuestos y alertas.

Casos de uso: e‑commerce y contenido editorial

E‑commerce

- Queries vagas: “para correr en montaña” → ranking por grip, impermeabilidad, reseñas.

- Compatibilidad: “cargador portátil macbook” → entidades de modelo, potencia, conectores.

- Soporte: RAG para “cómo calibrar mi smartwatch” con pasos y piezas.

Editorial/Docs

- Respuestas precisas con citas a secciones específicas.

- Navegación semántica: tópicos relacionados sin taxonomía rígida.

- Actualizaciones con re-embedding incremental y control de versiones.

Checklist de implementación

- Definiste intenciones y entidades por vertical.

- Diseñaste esquema con campos lex, facetas y vector.

- Elegiste modelo de embeddings en Bedrock adecuado para tu idioma.

- Implementaste chunking coherente y versionado de embeddings.

- Activaste búsqueda híbrida en Algolia con pesos iniciales.

- Instrumentaste métricas y pipeline de evaluación.

- Configuraste RAG con citaciones y límites de tokens.

- Plan de costes con cachés y cuotas.

Preguntas frecuentes rápidas

¿Debo abandonar las keywords?

No. Úsalas como señal dentro de un sistema híbrido. Lo que muere es la dependencia exclusiva de la coincidencia exacta.

¿Cuál es el mejor modelo de embeddings?

Depende del idioma, del dominio y de latencia/coste. Empieza con una opción generalista en Bedrock y evalúa con tus queries reales.

¿RAG en todas las páginas?

No. Prioriza donde aporte valor (soporte, comparativas, FAQs complejas) y controla costes con caché.

¿Cómo mido el éxito?

Combinando NDCG/Recall, CTR/conversión y satisfacción, más impacto en retorno.

Variaciones semánticas para reforzar la estrategia

- La desaparición de la keyword exacta en buscadores internos modernos.

- El fin de la concordancia exacta: cómo el dúo Algolia + Bedrock redefine la relevancia.

- Adiós a la palabra clave exacta: SEO centrado en intención y entidades.

- Más allá del matching literal: recuperación semántica y RAG productivo.

- La muerte de la coincidencia exacta y el auge del ranking híbrido.

Próximos pasos inmediatos

- Selecciona una categoría o sección piloto con volumen suficiente y queries variadas.

- Prepara un set dorado de 200–500 queries reales con relevancias etiquetadas.

- Implementa el pipeline mínimo de embeddings en Bedrock y búsqueda híbrida en Algolia.

- Establece KPIs y lanza un primer A/B con hipótesis claras de éxito.

- Documenta decisiones de chunking, pesos y reglas para iterar con velocidad y control.